如何训练自动驾驶汽车,让其对周围的世界有更深的认识?计算机能够从过去的经验中学习,从而认识到未来的模式,以帮助自动驾驶汽车安全地在不可预测的新情况下行驶吗?这些就是麻省理工学院(MIT)运输&物流中心的AgeLab与丰田安全技术协作研究中心(CSRC)试图解答的问题。据外媒报道,MIT与CSRC的答案就是共享了一个名为DriveSeg的创新开放数据集。

通过DriveSeg数据集的发布,可以知道MIT和丰田正致力于推进自动驾驶系统的研究,让该系统能够拥有像人类一样的感知能力,将驾驶环境视为连续的视觉信息流。首席研究员Bryan Reimer表示:“通过共享该数据集,我们希望鼓励研究人员、业内人士和其他创新者为临时AI建模研发新见解和新方向,以实现下一代辅助驾驶和汽车安全技术。”

CSRC高级首席工程师Rini Sherony表示:“预测能力是人类智能的一个重要组成部分。每当人类开车时,总是会跟踪周围环境的运动情况,以识别潜在的危险,做出更安全的决策。通过共享该数据集,我们希望加快对自动驾驶系统和先进安全功能的研究,让其更能适应周围的复杂环境。”

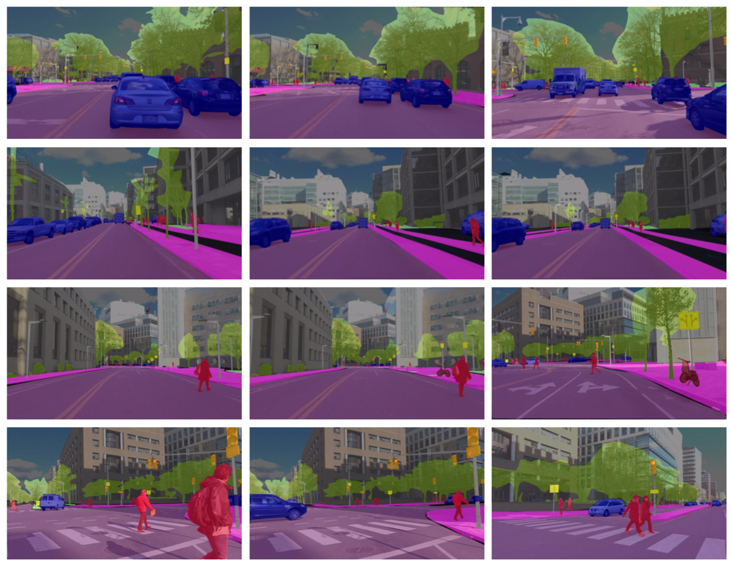

截至目前,已经向研究社区公布的数据集主要是由静态、单一的图像组成,可通过使用“边界框”识别和追踪道路内和道路周围的常见物体,如自行车、行人或交通信号灯等。相比之下,DriveSeg通过连续驾驶场景的视频镜头,对此类相同的常见道路物体进行了更精确的像素级表征。此种全场景分割对于识别没有特定、统一形状的不定形物体特别有用,如道路建筑和植被。

Sherony表示,基于视频的驾驶场景感知提供的数据流与动态的真实驾驶情况更接近,还能够让研究人员随着视频播放时间的增加而探索出数据模式,有助于在机器学习、场景理解和行为预测研究领域取得进展。

DriveSeg数据集免费提供,可供研究人员和学术团队用作非商业用途。其数据由两部分组成,DriveSeg(手动)是2分27秒的高清视频,拍摄于马萨诸塞州剑桥市白日繁忙街道的交通。该视频有5000帧,由人工密集地标注了12类道路物体的像素标签。

DriveSeg(半自动)是20,100个视频帧(6-10秒的视频片段),来自MIT先进汽车技术(AVT)联盟的数据。DriveSeg(半自动)与DriveSeg(手动)的像素语义注释相同,只是注释是通过MIT研发的一种新型半自动注释法完成。此种方法既利用人工,也利用计算机的能力,与人工注释相比,效率更高、成本更低。MIT和丰田创建该数据集的目的是为了评估,在大量真实世界驾驶场景中进行注释的可能性,并评估通过AI标签系统训练车辆感知系统的潜力。